◇「これができない」次々に克服/深層学習、多分野へ拡張

いま起きている第3次AIブームは深層学習が牽引し続けている。画像分類応用で深層学習が発表された当時、その高い性能は衝撃的であった。一方で、利用範囲や機能は限定的と思われていた。しかし、多くの研究者の注目を集め、研究開発が急速に進み、様々なタイプの構造を持った深層学習が発明され、多種多様な課題が次々と解決されていった。深層学習にはどのような課題があり、どう克服されてきたかを、応用分野と機能という視点から見ていく。

◇効率よい学習実装

第3次AIブームの火付け役はなんといってもニューラルネットワーク(NN)の深層学習である。従来のNNと深層学習の違いは、中間層がとても多いという以外に定義上の違いはない。しかし、効率よく学習するために様々な工夫が施されている点が実装上の違いといえる。深層学習が注目されたきっかけは、画像に写っているものを千種類に分類する、2012年に行われたコンテストである。優勝したのは、トロント大学のジェフリー・ヒントン教授が率いるチームが発表した深層学習(AlexNet)。誤認識が15.3%で、次点に対して10ポイント以上も低かった。AlexNetは畳み込みNNと呼ばれる種類で画像認識に適した構造をしていた。

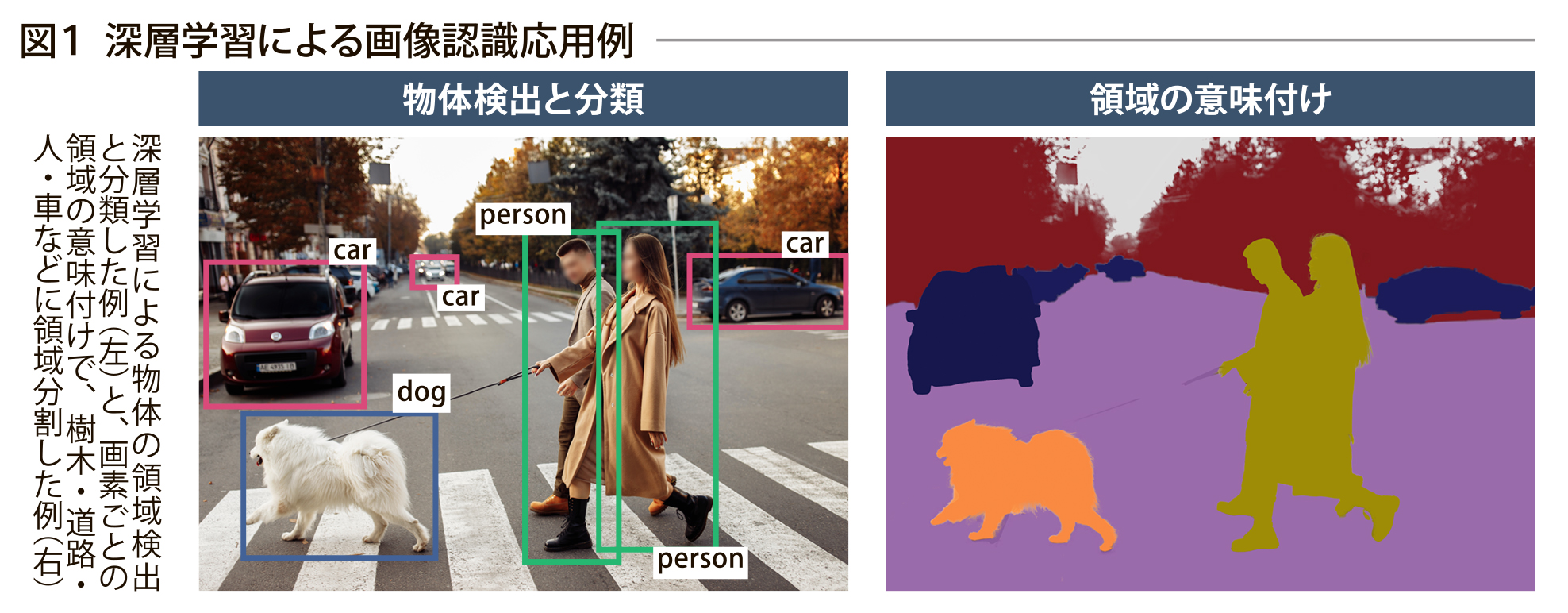

多くの研究者の興味を集め、“深層学習は「これができない」”という課題を克服するアイデアが短期間に考案され、この10年で驚くべきスピードで進化し続けてきた。画像処理のタスクも画像分類だけでなく、画像の中に写り込む対象領域を検出して分類する機能や、画素ごとに空・道路・人・車などに意味分けする機能など、次々と考案された。

発表当時、深層学習は画像処理・信号処理には向いているが、言語処理には向いてないと思われていた。しかし、言語処理系には、リカレントNN(RNN)など不定長の文章を入力し、先に出てきた文字が後の文字処理に影響を与える構造を持った深層学習が考案され、機械翻訳を可能にした。RNNは文章を一文字ずつ処理する必要があり、処理が遅かったので、固定長の文章を一度に並列処理できるトランスフォーマー(transformer)が考案された。このトランスフォーマーには、“どの文字同士の関係が重要か”を学習できるアテンション機能があり、これが劇的に言語処理性能を上げることになった。

◇まるで人との会話

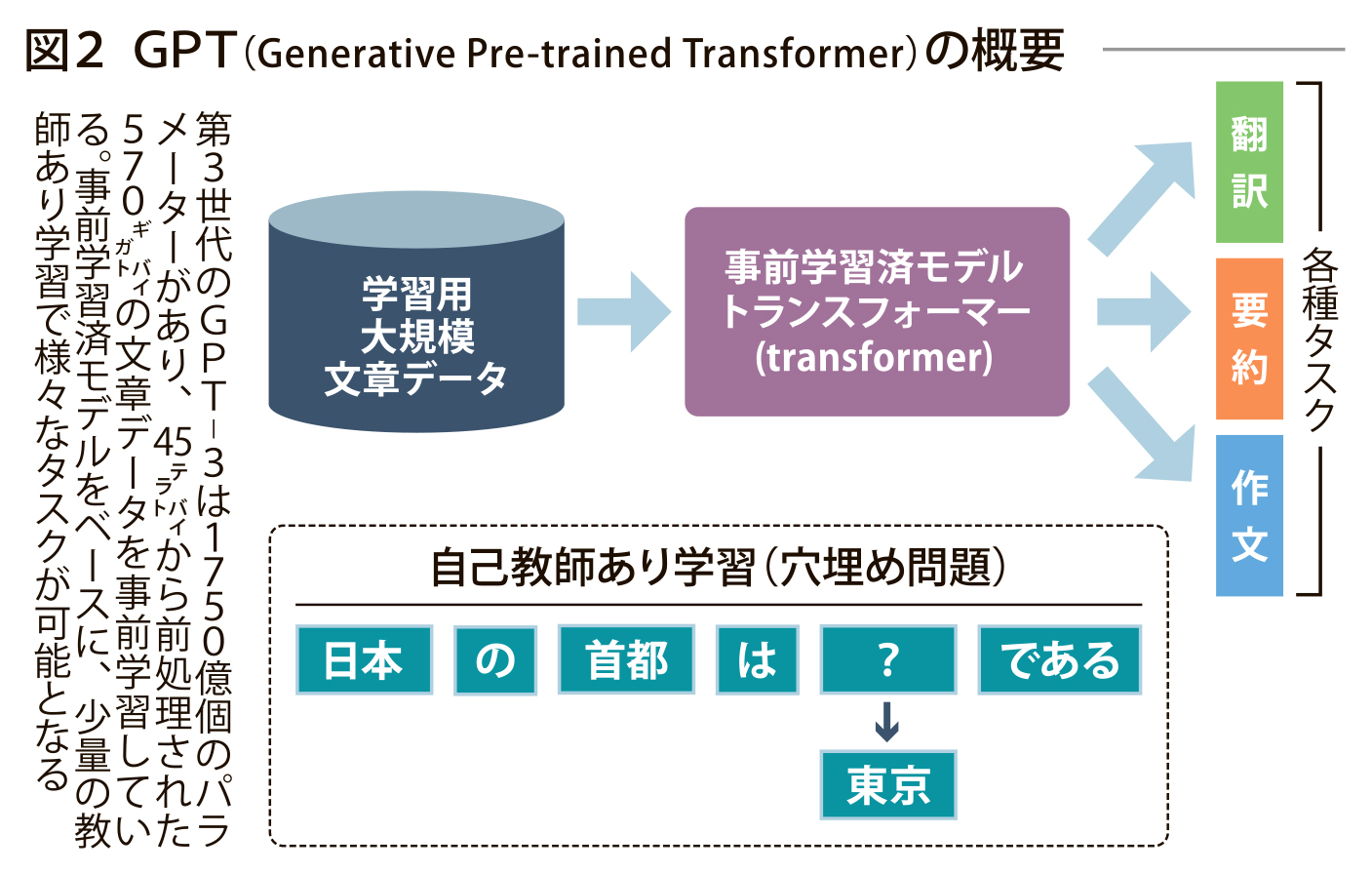

深層学習の弱点は、大量の教師あり学習データ(人が正解を示した学習データ)が必要というものであった。しかしその後、文章の一部を隠し、その部分を当てる自己教師あり学習が発案された。これにより深層学習が文字の意味と文法を、実質教師なしで事前学習することができた。大量のデータで事前学習した大規模言語モデル(GPT:Generative Pre-trained Transformer)は、それをベースに翻訳・要約・作文タスクを少量の教師あり学習データで行えるようになった。今後、大規模言語モデルは、言語だけでなく画像・映像・音声などが扱えるように拡張されつつある。ひとつの大規模AIモデルで複数のタスクが実現できるので、これを持って汎用AI(AGI:Artificial General Intelligence)と解釈する研究者もいる。自然言語で質問ができ、自然で的確な文章で回答する。まるで人と会話しているようである。

東芝でも現在では深層学習を用いた、機械翻訳・音声認識・人物認証・物体認識が主流であり、不可欠な存在となっている。その性能は平均的な人の能力を超えてきており、ブームはまだ続いている。

◆用語解説

◆畳み込みNN 局所的な領域に共通の重みづけフィルターの積和演算を行い、画像特徴を抽出するNN。共通の重みづけフィルターを誤差逆伝搬で学習するところが、これまでの機械学習と大きく異なる。

◆GPT OpenAIが開発した大規模言語モデル。多言語・プログラム言語を学習し、最新のものは画像も学習している。多言語が扱え、コンピュータのプログラム生成も可能である。OpenAIは、サム・アルトマン、イーロン・マスクらによって、人類に有益で安全な汎用AIの普及・発展を目的に設立されたAIの研究所。

電気新聞2023年4月10日