◇エキスパートシステムとニューラルネットワーク、それぞれの課題とその後

AIブームの再来は、知識を利用したエキスパートシステムが中心であった。また、ニューラルネットワーク(NN)の研究も再注目されていた。言語を中心とした研究は、パーセプトロンを批判したミンスキーが先導していた。知能とは人の知を指しており、言語を中核とした推論こそがAIにふさわしいと思われていた。一方で昆虫や動物の行動は言語に関係ないが、十分知的であると考えられていた。その当時のAIはどう見られていたか、なぜ再び冬の時代を迎えたのか。

◇知識と推論が分離

◇知識と推論が分離

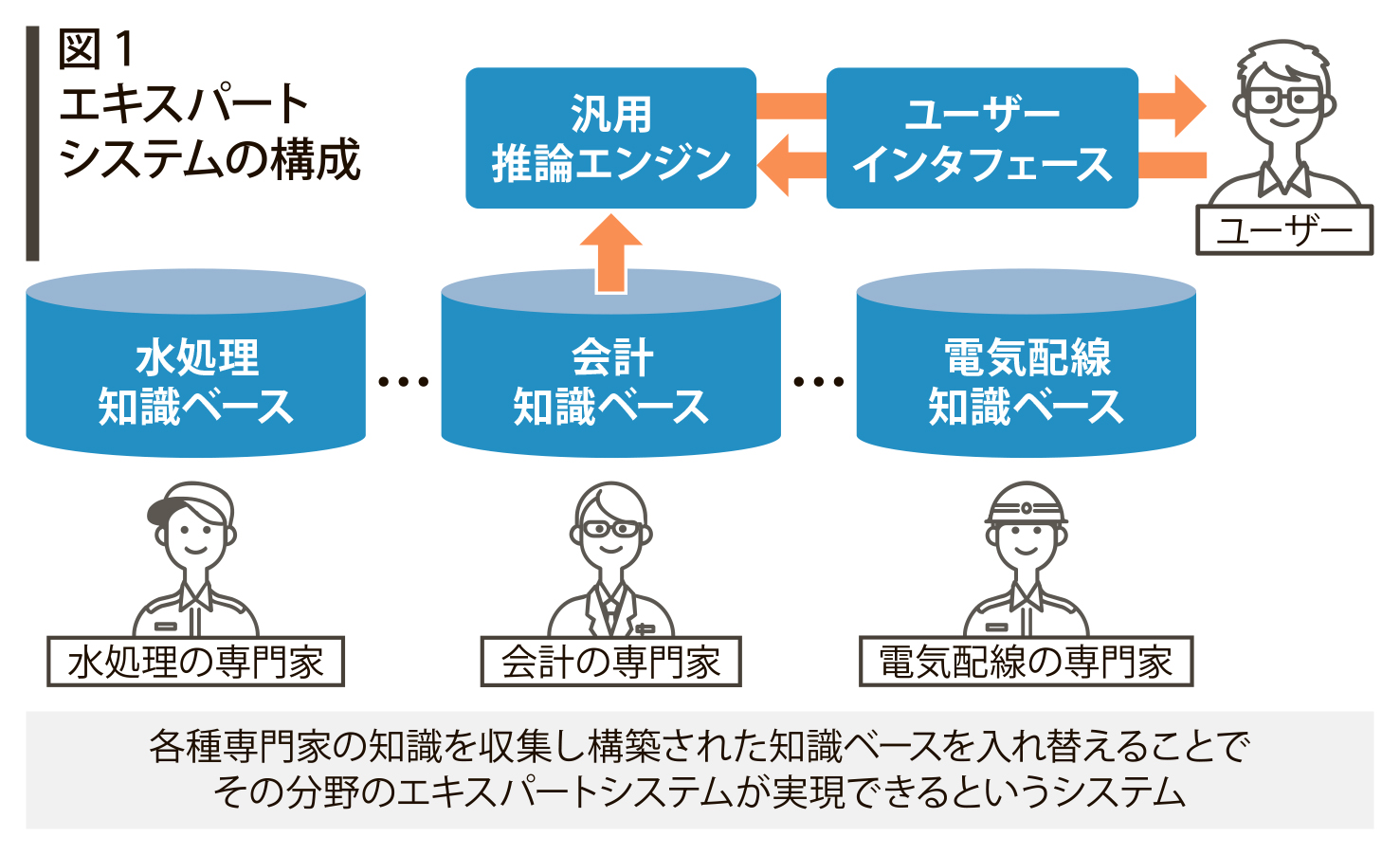

1980年代になって第2次AIブームが再来する。その中心にあったのがエキスパートシステムである。エキスパートシステムは専門分野の知識を使い、推論によって、ユーザーの質問に対する答えを導くというものである。そのシステムは専門分野に特化した知識ベースと汎用の推論エンジンが分離されていた。推論エンジンをそのままに、専門の知識ベースを取り換えれば、システムの大幅な変更なしに、あらゆる分野のエキスパートシステムが実現できるというアイデアであった。しかし、実際は、知識ベースの構築自体が大変な作業であった。また、古い知識を新しい知識に変えたり、付け加えたりした時のエキスパートシステムの振る舞いが予想できなかった。そのため、メンテナンス性が悪く、やがて熱は冷めていった。

この頃の研究の中心は、言語を中心とした知識操作のAIであり、マービン・ミンスキーがその先駆者であった。一方、同じMITのロボット工学の研究者であるロドニー・ブルックスは、昆虫や動物には言語とは異なる知性があるとし、言語偏重のAI研究を暗に批判した。言葉を持たない知的な動物を例に“象はチェスをしない”というフレーズで警鐘を鳴らしている。ブルックスは、外界とロボットのインタラクション(相互作用)を重視し、外界からの刺激に対する単純な反応(動作)の組み合わせで、複雑で知的な行動を制御する方法を考案した。このコンセプトで作られた掃除ロボットのルンバは、ブルックスが起業したアイロボット社の製品である。

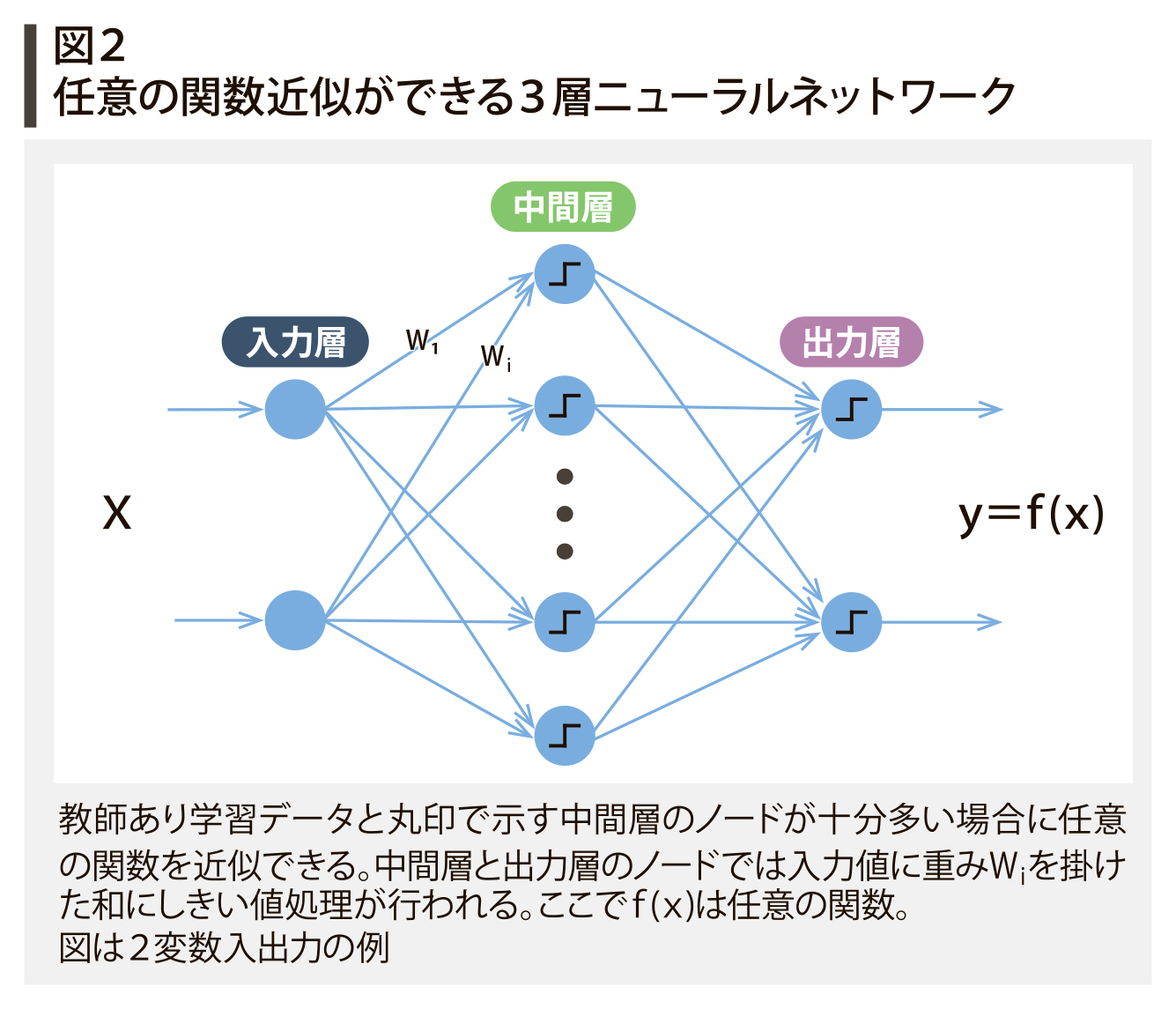

一方、NNも再度この時期に注目されている。それは、デビット・ラメルハートが86年に誤差逆伝搬法を考案し、NNの学習手法を確立したからである。また、3層のNNが任意の関数を近似できることが発見されたこともブームに火をつけた。しかし、学習用データと中間層のノードが十分多いことが前提であり、理論上はそうであっても、計算機の能力が不十分で実装は難しかった。多くの研究者が3層もしくは4層以上のNNの研究を進めたが、従来技術を上回る大きな成果は得られず、やがてNNの研究は下火となっていった。その状況でも、継続的にNNを研究していたグループがおり、のちに深層学習へと進化させた。

◇機械学習を製品化

◇機械学習を製品化

その頃、東芝では機械翻訳、音声認識、音声合成、文字認識、図面認識など様々な機械学習の研究をしており、製品化を実現していた。多くの手法は、NNではなく古典的な統計的機械学習を利用していた。機械翻訳はルールベースを用いており、機械学習を得意とするNNが後に機械翻訳の主流になるとは誰も考えていなかった。機械翻訳もエキスパートシステムと同じでルールと辞書のメンテナンスを行うことは大変苦労が多かった。しかし、機械翻訳は価値の高い機能と考えられ、ブームは去っても継続的に研究は続けられていた。

◆用語解説

◆マービン・ミンスキー MITで人工知能研究所を創設。AIの父と呼ばれ、ニューラルネットワークの1種である単純パーセプトロンの限界を示した。

◆ルールベース 人が推論ルールを機械にプログラムする方式。与えられた条件のもとに入力データに対して出力結果を出すルールが記述されている。その出力をさらに入力として推論を重ね、所望の出力を得る。

◆誤差逆伝搬法 ニューラルネットワークの出力値と正解値の誤差が小さくするように出力層から中間層そして入力層に遡ってネットワークを調整していく学習方法

電気新聞2023年4月3日