◇「ニューラルネットワーク」57年に萌芽/現在の「深層学習」へ進化

AIに関する記事が紙面に載らない日はない。AIすなわち人工知能(Artificial Intelligence)という言葉は、今から半世紀前に学術分野を議論する会議で、著名な学者が議論して生まれた。その当時において、AIの研究は何を目指そうとしていたのだろうか。また、現在その目標はどこまで達成できたのだろうか。ブレイクスルーを起こし第3次AIブームの火付け役となった深層学習は、その当時の技術からみてどのような位置にあるのかを歴史からひもといてみる。

人工知能という言葉が生まれたのは、1956年のダートマス会議とされている。ジョン・マッカーシー、マービン・ミンスキーらによって議論された。AI研究の目的は“機械によって、言語を使えるようにし、抽象化と概念の形成ができ、人しか解けない問題を解き、機械が自身の機能を改善する方法を探索する”とされた。このうち、現在実現しているものは、“機械が言語を使える”という機能である。長い文章の要約もできるが、文章の中身を理解していないので、抽象化・概念形成しているとはいえない。これまで、人にしかできないと思っていた問題解決のいくつかはできているが、ほんの一部だといって良い。また、機械が自らの機能を改善することもできない。大きな進歩はあったものの、まだまだ道半ばである。

◇“強い/弱いAI”

ダートマス会議で宣言されたAIは、“強いAI”に近い。“強いAI”とは、人のようになんでもできる知能を指す。現在主流のAIは“弱いAI”と呼ばれ、狭い領域に特化した機能を実現し、主に機械学習を中心としたAIのことである。機械学習とは教師となる学習用のデータからルールを学び、未知のデータをそのルールに従って分類や回帰(予測・推定)する機能である。

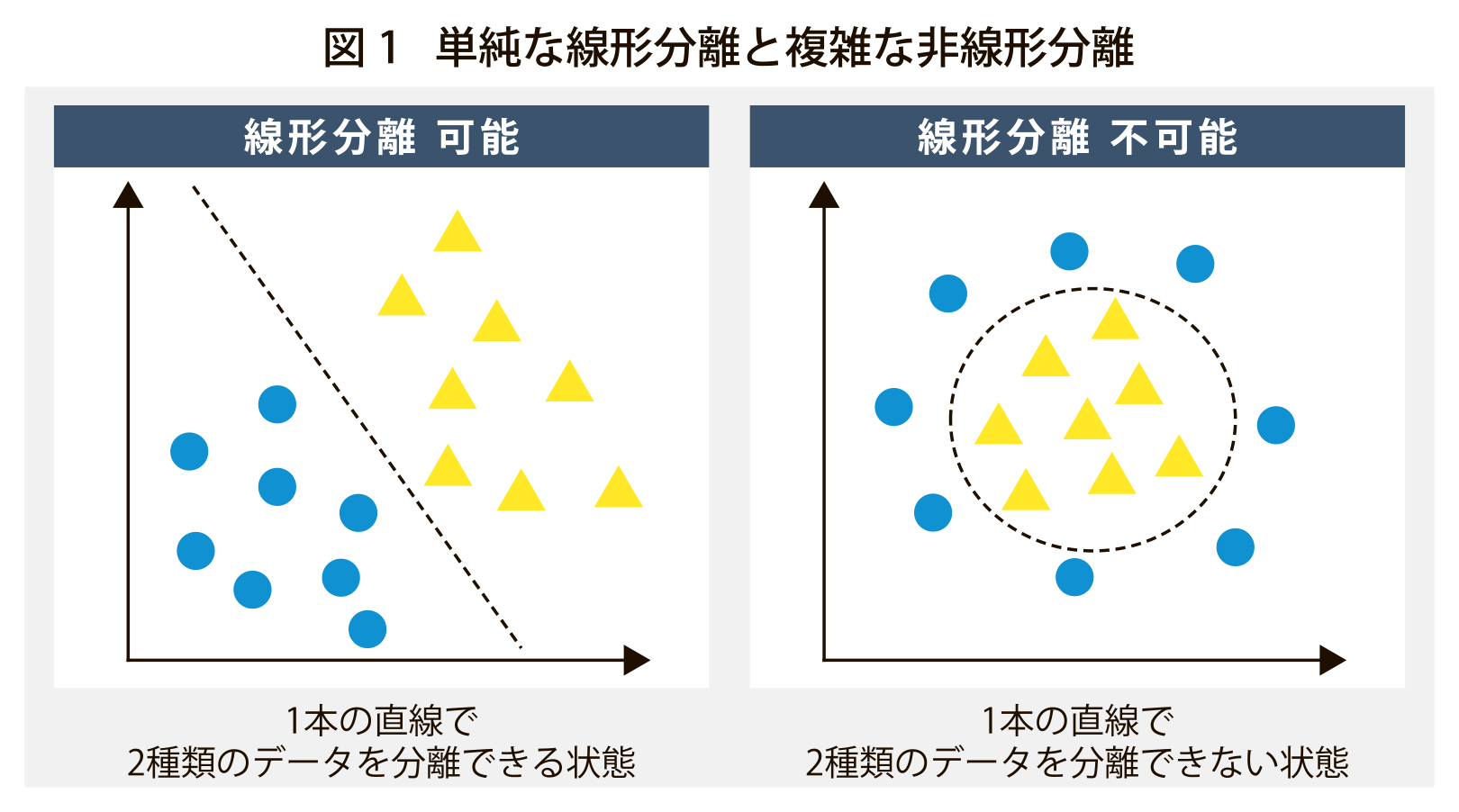

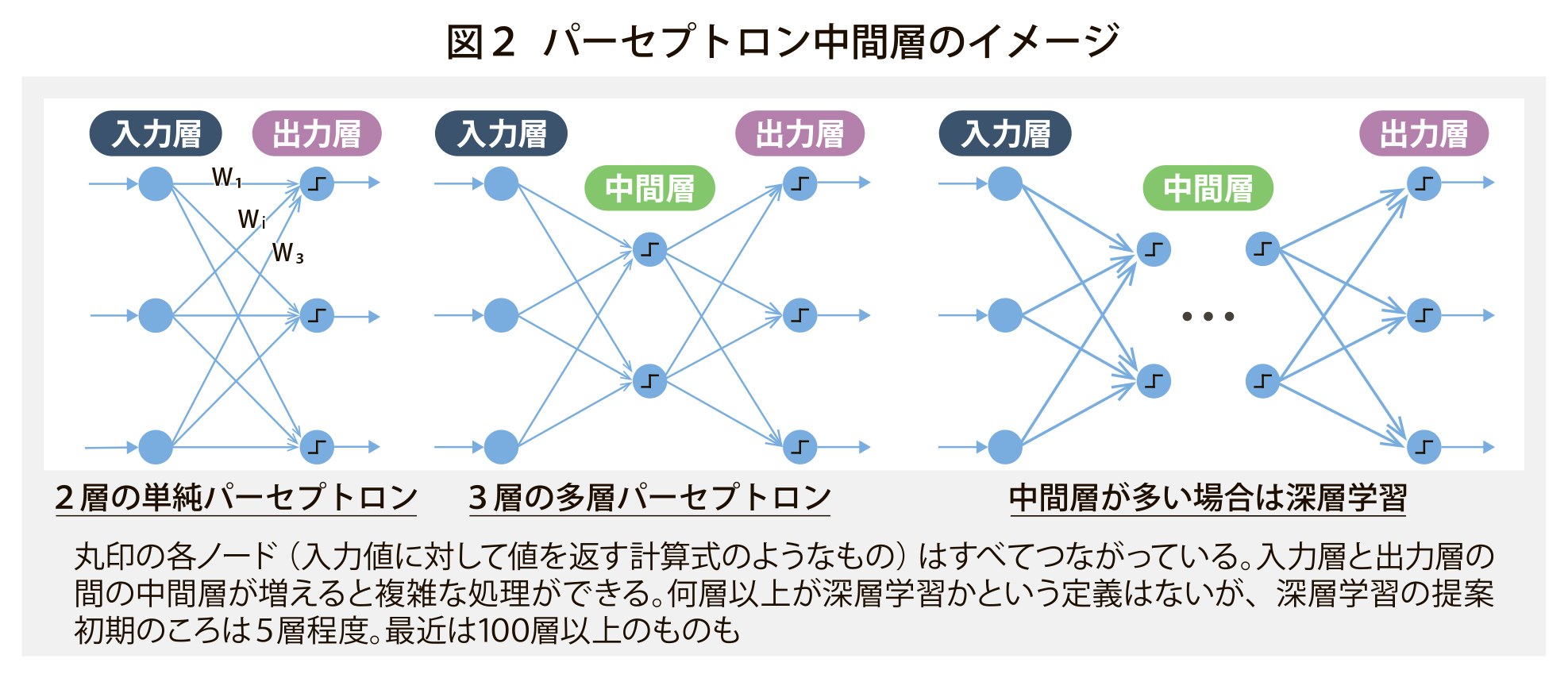

機械学習の手法は種々ある。その一つ、ニューラルネットワーク(NN、人の脳の構造をまねた数式的モデル)について触れよう。NNは、半世紀後に現在の深層学習へと進化する。57年にフランク・ローゼンブラットがNNの一種であるパーセプトロンを考案。69年のミンスキーとシーモア・パパートによる著書「パーセプトロン」で、入力と出力だけの2層の単純パーセプトロンは、線形分離可能なものしか分類できないと批判された。しかし、中間層を持つ多層パーセプトロンは、非線形分離可能であり、67年に東京大学の助教授であった甘利俊一氏によって、確率的勾配降下法という学習方法が考案されていた。

この確率的勾配降下法は、80年代の第2次AIブーム時に誤差逆伝搬法として再発見される。

この確率的勾配降下法は、80年代の第2次AIブーム時に誤差逆伝搬法として再発見される。

第1次AIブームであった、その当時の計算機能力が十分でなく、3層以上の多層パーセプトロンを用いて学習するのは困難で、注目されずに終わってしまった。そう考えると現在のAIを牽引している深層学習は、既に60年代に発明されていたといえる。

◇当時として画期的

その頃、東芝は67年に郵便物自動処理装置を開発し68年に製品化している。3桁の手書き文字を読む機械学習技術はAIではなくパターン認識と呼ばれていた。人の機能の一部を実現したという程度だったが、その当時にしては画期的だった。

◆用語解説

◆回帰 学習データから連続値の規則性を抽出し、未知データを予測すること。気温とある店の氷の売り上げの記録データから規則性を見いだし、次の日の予報気温から売上を予測するような応用に用いられる。

◆誤差逆伝搬法 出力値と正解の差(誤差)を出力層からさかのぼって、誤差が小さくなるようにネットワークの重みWを調整する学習手法

◆確率的勾配降下法 誤差逆伝搬法の具体的なやり方の一種。誤差が小さくなる方向(勾配)を見つけその方向にネットワークの重みwを調整する。学習データの一部をランダムに選ぶことにより、勾配方向にランダム性を取り入れ最適な解を探索できるようになる。

電気新聞2023年3月27日