◇適切な規制へ各国が準備開始/倫理・偏見のリスク注視

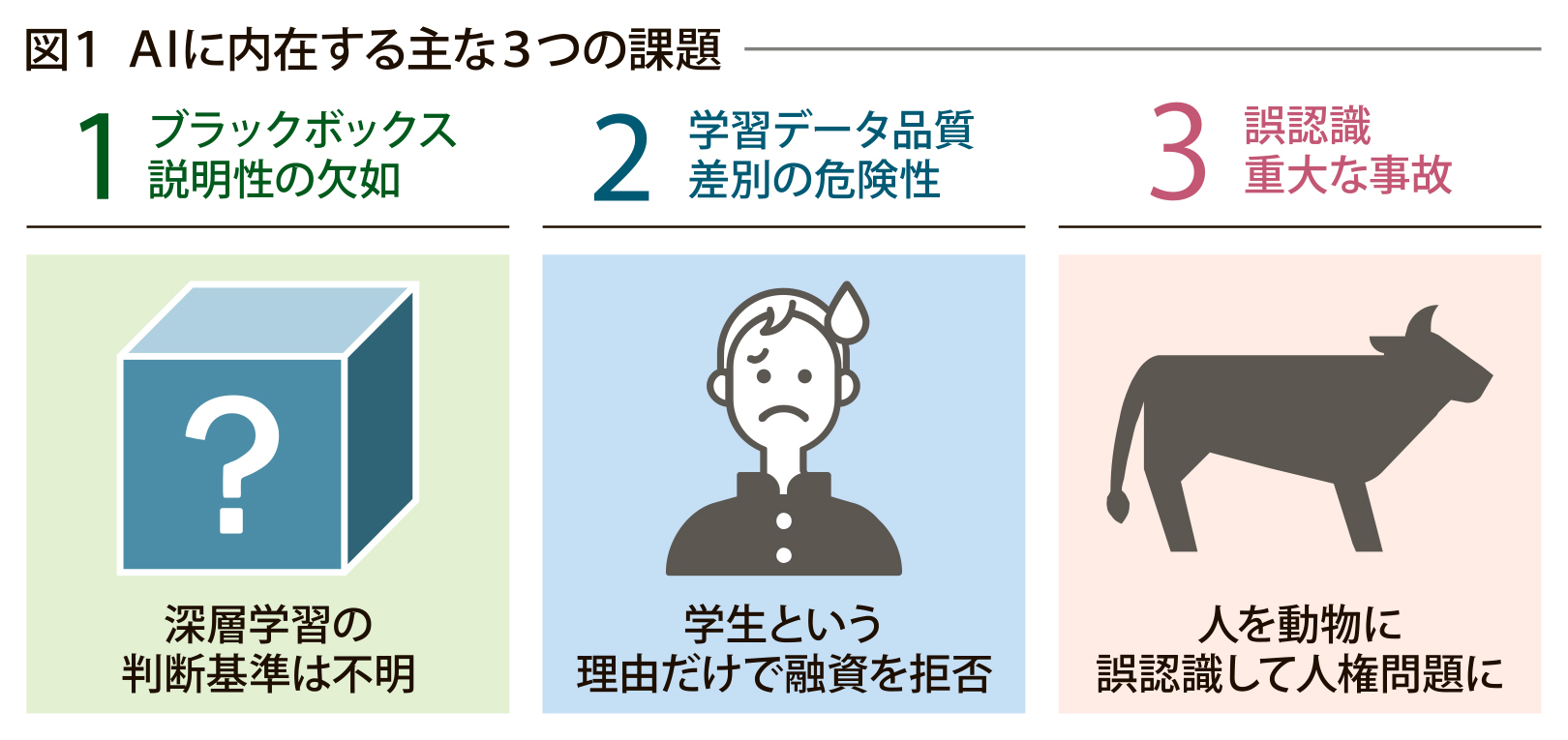

深層学習の進歩によって人類がAIから享受できる恩恵が拡大する一方で、差別・プライバシー侵害に繋がりかねない闇の部分も顕在化してきた。学習データによって機能を獲得するAIは、学習データに偏見が入っていた場合、AIモデルが偏見を持ってしまう危険性がある。そのため、AIシステムを規制する動きが各国で出てきた。規制だけにとどまらず、倫理的な議論も起こりつつある。AIにはどのような闇があるのかを具体的な事象でみていく。

◇レベル分け罰則も

深層学習が成果をあげる一方、出力結果の透明性・説明性が低いということで、2018年頃からAIに対する警鐘が鳴り始める。融資判定にAIが利用した学習データに、収入が少ない学生データが多くあり、応募学生の収入の大小に関係なく学生という属性だけで、融資をしないと判定するAIが問題になった。このバイアス(偏見)という現象は、学習データを正しく学習しないだけでなく、学習データにもともと偏見が入っているために発生する場合がある。また、ある写真分類をAIで行うサービスサイトで、写った人物を動物に誤認識し、人種差別問題として炎上。解決方法が見つからず、一時的にサービス停止に追い込まれた。

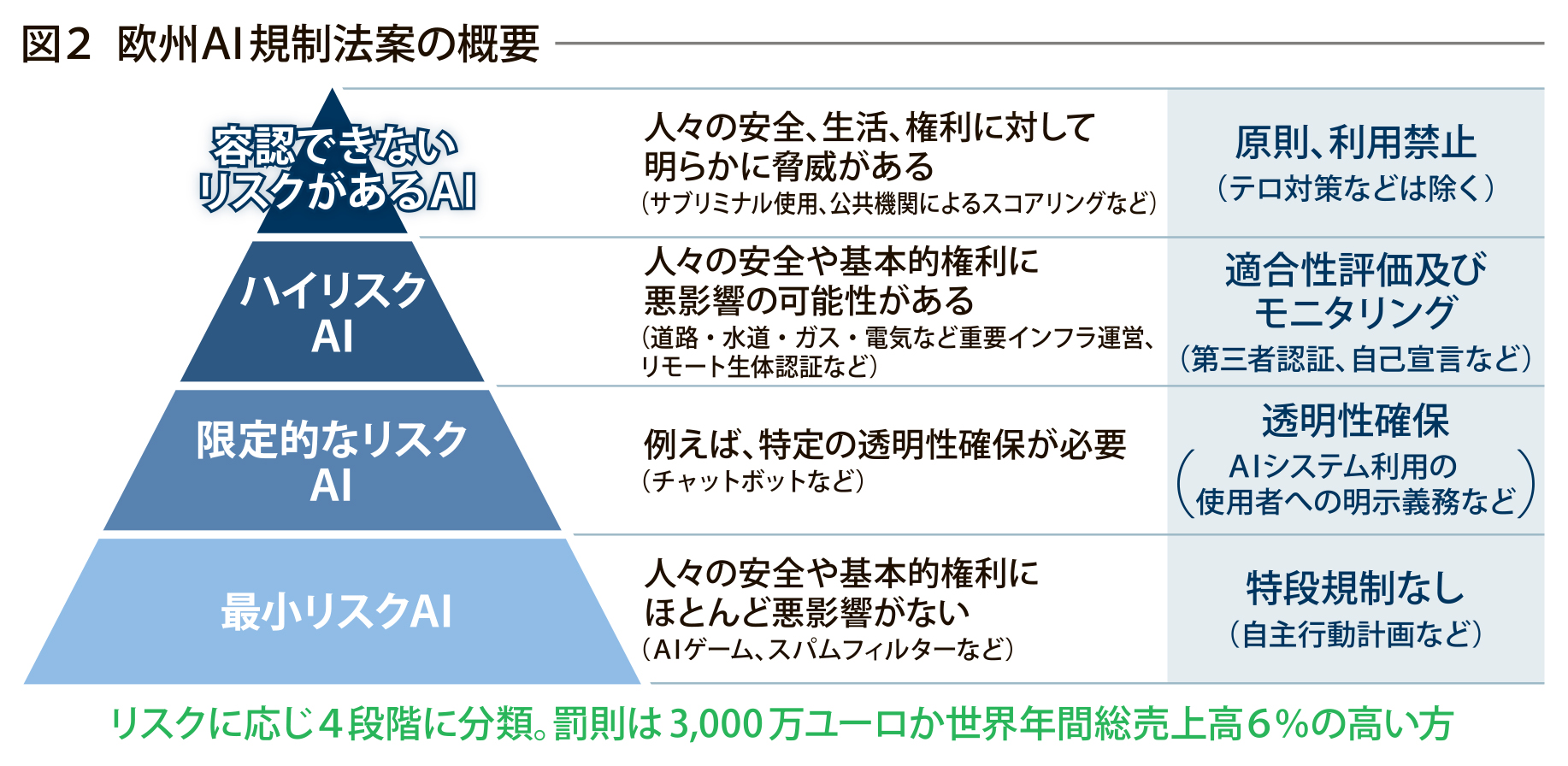

こうした中、AIには適切な規制が必要だという考えのもとに、各国が規制の準備をし始めた。日本はソフトローのガイドラインを中心に考えているが、欧州ではハードローのAI規制法案を準備し、2024年頃の公布を目指している。この欧州AI規制法案は、AIシステムを4レベルのリスクに分類し、規制を設けようとしている。

最上位の“容認できないリスク”は、サブリミナルや、公的機関による人の格付け機能を禁止している。最下位の“最小リスク”と“限定リスク”は、迷惑メールフィルターやチャットボットなどで、“限定リスク”は利用を明示すれば良い。最上位から2番目の“ハイリスク”は、重要インフラを運用するAIシステムや遠隔による人物監視AIシステムで、厳しいルールが設けられる予定である。

違反した場合は、全世界売上高の6%もしくは3千万ユーロの高い方が課せられる。その他にも、AIが大量殺戮兵器に使われたり、人のプライバシーを侵害したりする可能性から、倫理面からも議論が活発である。いくつかの大手企業ではコンプライアンスだけでなく、人権に関する倫理的なAIリテラシーを従業員全員が持つべきと考え、教育しようとしている。東芝もAIに対する姿勢を表明するステートメントは公表し、AIリテラシーの教育に取り組んでいる。

◇正しい「調教」とは

◇正しい「調教」とは

前回紹介したGPTは様々なタスクを実施できるが、人の質問に対して不適切な回答を出す場合もあり、倫理的な問題があると認識されていた。そのため、人と適切に対話できるように“調教”されたChatGPTが開発された。ChatGPTでは、人の質問に対して回答された文を人が点数付けし、どの回答が適切かを学ぶように、第3世代のGPT―3を“調教”したものである。

ChatGPTの“調教”は正しくできていると思われるが、“調教”した人の偏見が入り込まないように注意を払う必要があった。ChatGPTの精度があがるとホワイトカラーの職を奪うと懸念されており、今後社会的な問題として議論される可能性がある。

◆用語解説

◆ソフトロー/ハードロー ソフトローは、法的拘束力はないが従うことが勧められる行動規範。ハードローは、罰則規定があり法的拘束力がある。

◆サブリミナル 映像・音声などに意識されない短い画像・音を入れて潜在意識に働きかけること

◆ChatGPT イーロン・マスクらによって設立されたOpenAIが開発した大規模言語モデル(GPT―3)をベースに、人と自然言語で対話できるAI会話システム。倫理的な問題がない会話をするように調整されている。大規模言語モデルは少量の教師あり学習データで翻訳・要約・作文など様々なタスクを実現する。

電気新聞2023年4月17日